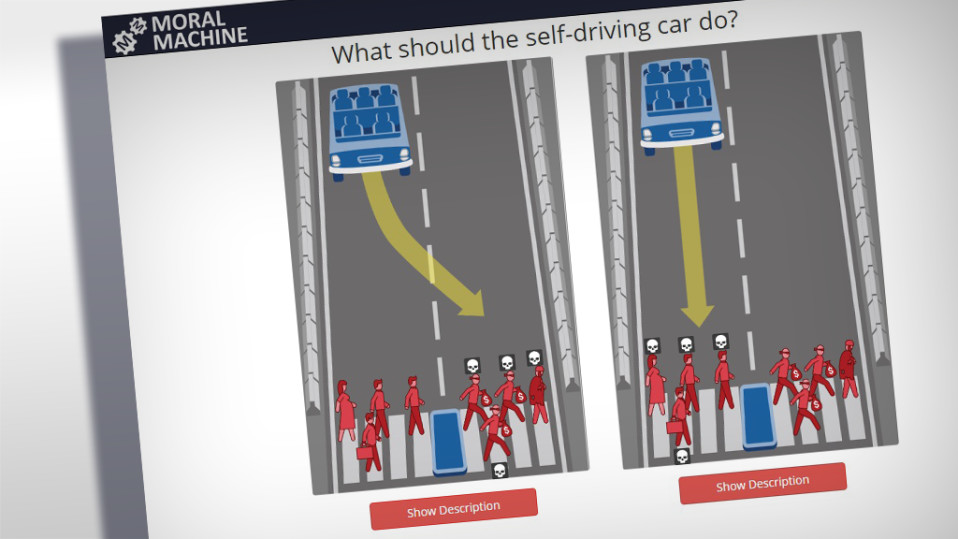

Robottiauto lähestyy punaisena palavia liikennevaloja, mutta jokin menee vikaan ja auto ei pysty hidastamaan vauhtia. Suojatiellä on kolme aikuista, jotka ovat jäämässä auton alle. Robottiauton kyydissä on nuori äiti ja tämän lapsi.

Itsestään kulkevan auton vaihtoehtoina on ajaa suojatiellä olevien ihmisten päältä tai ohjata auto tieltä ulos, jolloin auto törmäisi seinään.

Molemmissa tapauksissa ihmisiä kuolisi.

Esimerkiksi tällaisiin moraalisiin pulmiin pitää vastata Yhdysvaltalaisen MIT:n tutkijoiden tekemässä “moraalikoneessa”.

Tutkijoiden tarkoituksena on nettisivun avulla koota tietoa siitä, miten ihmiset haluaisivat tekoälyn ratkaisevan moraalisia ongelmia.

– Olemme saaneet noin 600 000 ihmiseltä vastauksia jo yli 12 miljoonaan erilaiseen tilanteeseen, jossa robottiauto on moraaliseen pulman edessä, MIT:n tohtoriopiskelija ja Moral Machinea kehittämässä ollut Sohan Dsouza kertoo sähköpostin välityksellä.

Moraalissa maantieteellisiä eroja

MIT:n nettisivuille tulleiden vastausten pohjalta on nähtävissä jo jonkinlaisia moraalisia suuntaviivoja. Kone näyttää vastaamisen jälkeen, että monet arvostavat esimerkiksi ihmisten henkeä selvästi korkeammalle kuin eläinten.

Myös lapsia suojellaan mieluummin kuin vanhuksia. Lisäksi useimmat haluavat pitää kuolonuhrien lukumäärän mahdollisimman pienenä.

Dsouzan mukaan tutkijat eivät kuitenkaan ole vielä halunneet tehdä tarkkoja analyyseja tai johtopäätöksiä kerätyn tiedon pohjalta, sillä he odottavat lisää aineistoa.

Joitain kaavoja ihmisten moraalista on alkanut kuitenkin hahmottua. Esimerkiksi “läntisistä” ja “itäisistä” maista kotoisin olevien ihmisten vastauksissa on keskimäärin ollut havaittavissa jonkin verran eroja.

Länsimaiset vastaajat pyrkivät keskimäärin pitämään robottiautojen aiheuttamien kuolonuhrien määrän mahdollisimman alhaisena. Sohan Dsouza, tohtoriopiskelija, MIT

– Länsimaiset vastaajat pyrkivät keskimäärin pitämään robottiautojen aiheuttamien kuolonuhrien määrän mahdollisimman alhaisena ja näin ollen hyväksyvät enemmän utilitaristisia eli suurimman hyödyn valintoja.

Moraalinen kaava, joka miellyttää suurinta osaa

Moraalikoneen yhtenä tarkoituksena on Dsouzan mukaan rakentaa sosiaalipsykologeille ja eetikoille kaavoja ja jonkinlainen “yleinen totuus” siitä, kuinka ihmiset näkevät koneiden tekemät moraaliset ratkaisut.

– On kuitenkin vielä eri kysymys, tullaanko näitä kaavoja todella käyttämään tulevaisuudessa itsestään kulkevien autojen kehittämisessä. Se vaatisi paljon keskusteluja ja pohtimista valtiollisten tahojen, vakuutusyhtiöiden, autonvalmistajien, tekoälytutkijoiden ja suuren yleisön kanssa, Dsouza pohtii.

Helsingin yliopiston kognitiotieteen yksikön tutkijatohtori Michael Laakasuo tutkii työkseen robotiikan moraalipsykologiaa eli ihmisten suhtautumista koneiden suorittamiin päätöksiin.

Vastausten perusteella voitaisiin esimerkiksi pelkistää yleinen kaava, joka miellyttäisi esimerkiksi 90:tä prosenttia ihmisistä. Michael Laakasuo, tutkijatohtori, Helsingin yliopisto

Tutkijatohtorin mukaan ihmiset eivät välttämättä osaa sanallistaa, miten he haluaisivat robottiautojen ja -kulkuneuvojen toimivan. Moraalikoneen kaltaisen nettisivun avulla voidaan kuitenkin kerätä suurelta määrältä ihmisiä mielipiteitä siitä, miten itsestään ajavan auton eri liikennetilanteissa pitäisi toimia.

– Vastausten perusteella voitaisiin esimerkiksi pelkistää yleinen kaava, joka miellyttäisi esimerkiksi 90:tä prosenttia ihmisistä.

Laakasuon mukaan tällaisen kaavan avulla robottiautot voisivat todennäköisesti välttää sellaisten ongelmatilanteiden tapahtumisen, jotka voisivat saada ihmiset vihamieliseksi tai epäileväksi itsestään ajavia autoja kohtaan.

Autoihin ei voi ohjelmoida tilannetajua

Tällä hetkellä tekoäly ratkaisee moraaliset tilanteet samalla tavalla kuin suuri joukko ihmisiä. Michael Laakasuon mukaan kone ei pysty olemaan sen moraalisempi kuin mitä se on ohjelmoitu olemaan.

– Ohjelmoijat ja kyseisen teknologian rakentajat tekevät moraaliset valinnat meidän puolestamme.

Tehtävä on vaikea, koska liikenteessä on niin paljon muuttujia ja yllättäviä tilanteita, jotka kaikki tekoälyn pitäisi tunnistaa. Laakasuon mukaan ihmisillä on luontainen kyky ymmärtää tilanteita, jotka ovat moraalisia, mutta koneilla tätä kontekstin tajua ei ole.

Ohjelmoijat ja kyseisen teknologian rakentajat tekevät moraaliset valinnat meidän puolestamme. Michael Laakasuo

– On hankalaa, ettei itsestään kulkeviin autoihin voida suoraan ohjelmoida yleistä vaaran käsitettä tai tilannetajua. Voimme vain ohjelmoida erilaisia oletuksia, mitä ympäristössä tapahtuu, Laakasuo sanoo.

Juuri tästä syystä yleisten moraaliin liittyvien lähdekoodien ohjelmoinnin pitäisikin olla Laakasuon mielestä kaikille avointa ja siitä pitäisi julkisesti keskustella.

Muuten voi Laakasuon mukaan olla vaarana, että yksityiset yritykset kehittävät ohjelmistoteknologian ja niiden periaatteet salassa, jolloin ei tiedetä, kenen moraalikäsitystä ja etuja ne noudattavat.